Die steigende Nutzung von KI-Tools öffnet den Raum zu schnellen Antworten. Jeder Prompt erhält in kurzer Zeit selbstsicher formulierte und gut strukturierte Ergebnisse, oft macht der Verweis auf Studien oder Daten & Fakten die Inhalte noch fundierter. Aber es kommt immer wieder vor, dass beim genauen Betrachten Ungereimtheiten und nicht belegte Quellen entdeckt werden. Das kritische Lesen und Verarbeiten von Informationen gehört zu den wesentlichen Kompetenzen im „Zeitalter der alternativen Fakten“. Der Artikel regt zum Nachdenken und Entdecken beim Medienkonsum an.

Der Verfasser des Artikels begibt sich gerne als Wanderer in die Berge, um neue Regionen und Gipfel zu entdecken. Vorbereitet durch das Lesen der Beschreibung in einem Wanderführer und ausgestattet mit einer gedruckten Wanderkarte, gibt es große Vorfreude auf das neue Abenteuer. In vielen Gebirgszügen gibt es hilfreiche Markierungen, durch Schilder bzw. oft rot-weiß-rote Markierungen auf Steinen oder Baumstämmen.

Aber es gibt immer wieder einzelne Situationen, in denen die weitere Wegrichtung unklar wird: es gibt eine Abzweigung mit zwei Wegen, beide scheinen zu stimmen. Vor allem bei schlechtem Wetter oder bei kleineren Wegen abseits der Forststraßen ist die Entscheidung manchmal von Unsicherheit geprägt. Man geht voran, aber das bestätigende Gefühl der nächsten Markierung fehlt. Stimmt der Weg? Stimmt die Richtung? Man vergleicht kritisch die Relationen am Plan und im Gelände, bis die (im Nachgang oft richtige) Entscheidung zum Umkehren getroffen wird.

Prompts liefern Zeit selbstsichere, gut formulierte Antworten. Bei genauerem Hinschauen ist es aber oft ein Zusammenspiel aus „Schein und Sein“.

Mehr digital ist die Wegbegleitung beim Auto-Navigationsgerät. Man gibt mit Sprache (das funktioniert nicht immer) oder über Tasten das gewünschte Ziel ein. Man verlässt sich auf die Wegbeschreibung am Display. Man hört in den Medien immer wieder, dass Autofahrer beim unreflektierten Übernehmen der Empfehlungen auf Fußwegen oder abseits gelegenen Forststraßen mit Fahrverbot gelandet sind. Das kann insbesondere passieren, wenn das Navi auf die direkteste Wegverbindung eingestellt ist. Das Navigationsgerät wirkt immer selbstsicher, durch konsequentes Anzeigen der Wegstrecke oder durch das Ansagen mit angenehmer Stimme. Ein kritischer Blick auf die Straße und die Rahmenbedingungen ist immer empfehlenswert.

Die beiden Beispiele veranschaulichen den Umgang mit KI-Plattformen wie ChatGPT oder Gemini. Basierend auf den eingegebenen Prompts gibt es immer nach kurzer Zeit selbstsichere Antworten, sie wirken strukturiert und gut formuliert. Doch bei einem genauen Faktencheck erkannt man immer wieder ein Zusammenspiel aus „Schein und Sein“ bzw. „Fakt und Fake“. Der vorliegende Artikel regt zum Nachdenken beim Gebrauch der KI-Tools an, es ist auch ein Plädoyer für die kombinierte Beschäftigung mit klassischen – von fundierter Recherche geprägten – Journalismus-Artikeln veröffentlicht auf anerkannten Websites und in seriösen Fachmedien.

Die Funktionsweise von KI-Bots

Jedes Wissen bedarf einer Grundlage, das können die Beschäftigung mit einem Thema oder Erfahrung sein. Das Trainieren der Fähigkeiten ist auch die Basis für das Funktionieren der künstlichen Intelligenz. KI-Tools wie ChatGPT oder Gemini sind mit großen Mengen von Daten trainiert, dazu zählen Bücher, Artikel, Website und sonstige Quellen. Das Modell erlernt aus dem Input sprachliche Muster und erkennt Zusammenhänge, welche der Hintergrund für den Output bei Anfragen sind.

Beim Generieren der Ergebnisse arbeitet das KI-Modell mit Wahrscheinlichkeiten, es gibt Wort für Wort eine Vorhersage der am wahrscheinlichsten passenden Wortfolge. Künstliche Intelligenz „versteht“ keine Inhalte wie ein Mensch, es liefert nur statistisch zusammenhängende Antworten mit einer hohen Sinnhaftigkeit. In jeder Wahrscheinlichkeit steckt ein hoher Prozentanteil von Wirklichkeit, kombiniert mit selektiven Unwahrheiten.

Kritisches Hinterfragen und Studien bestätigen die Fehleranfälligkeit

Der Verfasser des vorliegenden Artikels ist beim Recherchieren von Studien zum Fachthema „SEO vs. GEO“ über die KI-Plattform ChatGPT stutzig geworden. Basierend auf einem passenden Prompt werden als Teil vom KI-Output konkrete Studienergebnisse inkl. %-Werte zum geänderten Suchverhalten ausgewiesen. Beim vertiefenden Nachfragen zur exakten Quelle antwortet der KI-Bot mit in Richtung Frechheit gehender Selbstverständlichkeit, dass es die Studie nicht gibt und die %-Werte nur „illustrativ“ gemeint waren.

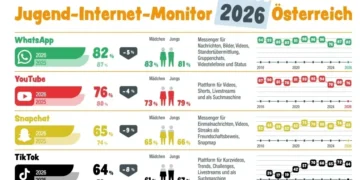

Eine aktuelle Studie der Europäischen Rundfunkunion (EBU), welche von der BBC koordiniert wurde, offenbarte ausgeprägte Schwachstellen. Es wurden 3.000 Antworten von KI-Assistenten in 14 verschiedenen Sprachen ausgewertet, dabei entdeckte man bei 45 % der Antworten zumindest eine wesentliche Verzerrung bei den Inhalten, dazu zählten auch fehlerhafte Zitate und Quellenverweise. Das hohe Risiko bei manipulierten Trainingsdaten untersuchte eine akademische Forschung durch ein Team internationaler Wissenschafter, die Anfälligkeit von Large Language Models (LLM) durch wenig „Poison“ ist besorgniserregend.

Kritische Reflexion als Gegenpol zu Halluzinationen

Unter einer Halluzination (der Ursprung liegt im lateinischen Wort „alucinatio“, das bedeutet Träumerei oder gedankenloses Reden) versteht man eine Wahrnehmung, für welche keine Grundlage vorliegt. Eine Halluzination in Verbindung mit künstlicher Intelligenz ist das Generieren von falschen oder irreführenden Informationen, welche trotz fehlender Fundierung mit Fakten plausibel klingen. Es schließt sich der Kreis zu den Wahrscheinlichkeiten, mit denen KI-Modelle Wort für Wort Antworten entwickeln. Bei fehlenden Grundlagen werden Lücken kreativ gefüllt.

Basierend auf der oben angeführten Studie empfiehlt die Europäische Rundfunkunion (EBU), den Ergebnissen der KI-Bots niemals blind zu vertrauen. Es wird geraten, wesentliche Informationen immer einem Gegencheck zu unterziehen. Besonders bei politischen Themen bzw. Fragen rund um Gesundheit und finanzielle Entscheidungen ist hohe Vorsicht geboten.

In einem sich verändernden Umfeld, in welchem dynamische Entwicklungen wie die wachsenden Möglichkeiten der Tools der künstlichen Intelligenz (von Text über Bild bis Video) zu Erstaunen führen, gewinnt die kritische Reflexion an Stellenwert. Das kritische Hinterfragen wird zu einer wesentlichen Kompetenz, zusätzlich gilt es Personen wie seriöse Journalisten bzw. fundierte Medien wie Fachmagazine und Nachrichtenportale zu schützen.

Zusammenfassend: Die schnelle Antwort, welche gut strukturiert und plausibel erscheint, ist nicht immer die beste und richtige Antwort. Der „Faktencheck“ gehört zunehmend zum „kleinen 1 x 1“ der kritischen Reflexion. Wir leben in einem sich rasch verändernden Umfeld, möge das „Sein“ mit Fakten & Fundierung mehr zählen als der „Schein“ mit Halluzinationen & kreativen Schnelllösungen.

Harald Rametsteiner

UPGROW Marketing Consulting

Lehrgangsleiter MBA General Management der FH des BFI Wien & E-Learning Group

© ELG Ricardo Randl